我从事教育相关工作,我需要搭建一个本地的中文大语言模型推理服务,因为经费紧张,没有GPU,而 Ollama 结合 qwen 模型能够在CPU下提供比较不错的反应速度,所以我尝试了通过Docker Compose在本地的Debian服务器上搭建一个基于Ollama和Open-webui的服务.

搭建服务

|

|

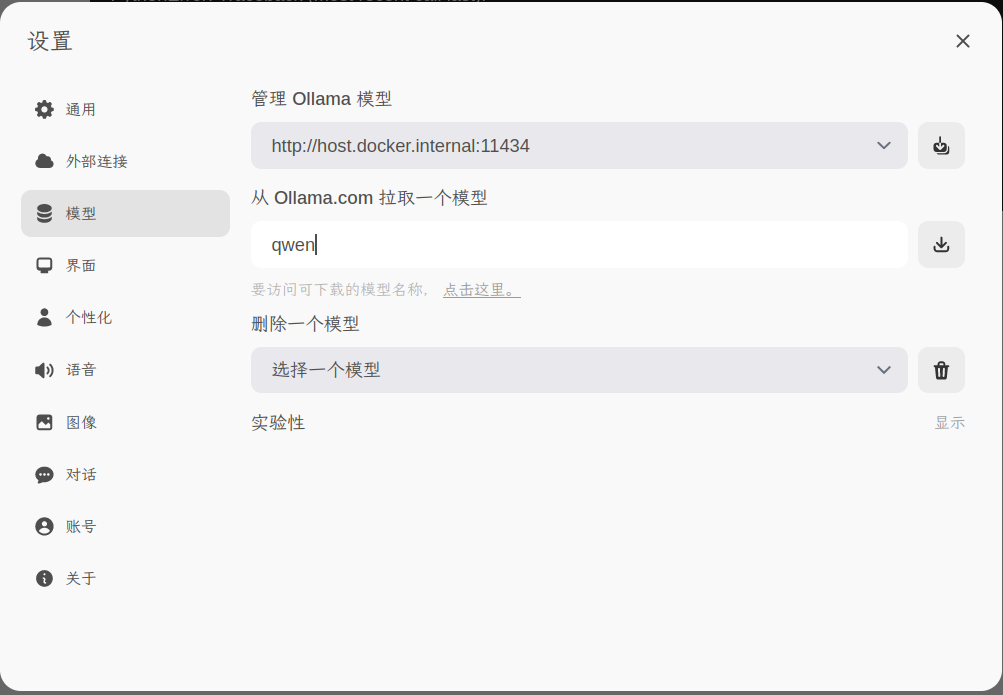

之后可以通过 docker compose up -d 命令启动服务, http://localhost:8080 可以看到Open-WebUI的服务,第一个注册的用户将会被自动赋予管理员的权限.接下来就可以选择左下角的菜单中的设置添加模型.

添加模型

通过网页添加

所有可用的模型可以在 https://ollama.com/library 这里查看,在拉取模型那里输入名称就可以拉取下来.因为我的需求,我主要选择了 qwen 和 codeqwen ,版本自然比当前通义千问的官网的版本低一些,但对于我的需求来说够用了.

docker命令进入容器内部添加

或者,你也可以通过docker命令进入容器内部用如下命令抓取.

|

|

使用

除了基本的问答之外,Open-WebUI 也可以运行提示的代码

还有更多功能正在摸索中…